Algorisme del gradient descendent

L'algorisme del gradient descendent és un mètode iteratiu d'optimització de primer ordre per a trobar el mínim d'una funció. S'anomena descendent perquè el prenen els increments proporcionals al negatiu del gradient de la funció. Si es prenen increments positius al gradient, s'anomena gradient ascendent.[1][2][3]

Aquest mètode s'empra sovint com una extensió de l'algorisme de retropropagació usat en l'entrenament de xarxes neuronals artificials.

Descripció

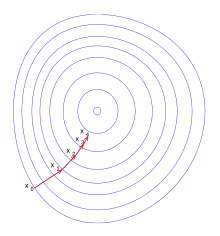

[modifica]El gradient descendent es basa en el fet que si la funció multivariable està definida i és derivable al voltant d'un punt , llavors decreix de la manera més ràpida si es va des del punt en direcció del gradient negatiu de en , o sigui . Aleshores la seqüència de punts és:

o també:

i la seqüència és monotònica descendent:

Referències

[modifica]- ↑ «Keep it simple! How to understand Gradient Descent algorithm» (en anglès). https://www.kdnuggets.com.+[Consulta: 14 novembre 2018].

- ↑ S, Suryansh. «Gradient Descent: All You Need to Know» (en anglès). https://hackernoon.com,+12-03-2018.+[Consulta: 14 novembre 2018].

- ↑ «Gradient Descent in a Nutshell – Towards Data Science». Towards Data Science, 07-03-2018. Arxivat de l'original el 2019-05-01 [Consulta: 14 novembre 2018]. Arxivat 2019-05-01 a Wayback Machine.