Arbre de decisió

Un arbre de decisió és una eina de suport a la presa de decisions que empra un model gràfic en forma d'arbre per expressar les decisions i les seves possibles conseqüències, incloent-hi les probabilitats de què succeeixin certs successos, els costos i les utilitats.

S'usa en àmbits tan diversos com intel·ligència artificial i l'economia. L'arbre és una manera d'especificar un algorisme que conté controls condicionals.[1][2][3][4]

Propietats

[modifica]

Un arbre de decisió és una estructura similar a un diagrama de flux en què cada node intern representa una "prova" sobre un atribut (per exemple, si quan tirem una moneda aquesta sortirà cara o creu), cada branca representa el resultat de la prova i cada mode de fulla representa una etiqueta de classe (decisió presa després de calcular tots els atributs). Els camins d'arrel a fulla representen regles de classificació.

En l'anàlisi de decisions, un arbre de decisió i el diagrama d'influència estan estretament relacionats, ja que els utilitzem com a eina de suport visual i analític a la decisió, on es calculen els valors esperats (o la utilitat esperada) de les alternatives competidores.

Un arbre de decisió està format per 3 tipus de nodes:[5]

- Node de decisió: típicament representat per quadrats.

- Nodes casuals: típicament representat per cercles

- Node final: típicament representat per triangles.

Els arbres de decisió s'usen habitualment en la investigació operativa i la gestió d'operacions. Si, a la pràctica, les decisions s'han de prendre en línia sense recordar-les sota coneixements incomplets, un arbre de decisions hauria d'anar paral·lel a un model de probabilitat com a model de millor elecció o algorisme de model de selecció en línia. Un altre ús dels arbres de decisió és com a mitjà descriptiu per calcular probabilitats condicionals.

Construcció d'un arbre de decisió

[modifica]Expliquem com es construeix un arbre de decisió. Per fer-ho, haurem d'explicar primer una sèrie de coses:

Elements

[modifica]

Els arbres de decisió estan formats per nodes, vectors de nombres, fletxes i etiquetes:

- Cada node es pot definir com el moment en què s'ha de prendre una decisió entre diverses possibles, el que va fent que a mesura que augmenti el nombre de nodes augmenti el nombre de possibles finals als quals pot arribar un individu. Això fa que un arbre amb molts nodes sigui complicat de dibuixar a mà i d'analitzar a causa de l'existència de nombrosos camins que poden seguir.

- Els vectors de nombres serien la solució final a la qual s'arriba en funció de les diverses possibilitats que es tenen, donen les utilitats en cada solució.

- Les fletxes són les unions entre un node i un altre, i representen cada una de les accions realitzades.

- Les etiquetes es troben en cada node i cada fletxa i donen nom a cada acció.

Conceptes

[modifica]Quan parlem del desenvolupament d'arbres, utilitzarem sovint aquests conceptes:

- Cost. Es refereix a dos conceptes diferents:

- # El cost de mesurament per a determinar el valor d'una determinada propietat (atribut) exhibit per l'objecte en qüestió.

- # El cost de classificació errònia quan es decideix que l'objecte pertany a la classe X quan la seva classe real és la Y.

- Sobreajust (Overfitting). Es produeix quan les dades d'entrenament són pocs o tenen incoherències. En prendre un espai d'hipòtesis , es diu que una hipòtesi sobreajusta un conjunt d'entrenament si existeix alguna hipòtesi alternativa tal que classifica millor que els elements del conjunt entrenament, però classifica millor que el conjunt complet de possibles instàncies.

- Poda (Pruning). La poda consisteix a eliminar una branca d'un node transformant-lo en una fulla (terminal), assignant-li la classificació més comuna dels exemples d'entrenament considerats en aquell node.

- Validació encreuada. És el procés de construir un arbre amb la majoria de les dades i després utilitzar la part restant de les dades per a provar-ne la precisió de l'arbre.

Regles de decisió

[modifica]En els arbres de decisió s'han de complir una sèrie de regles de decisió:

- Al començament del joc, es dona un node inicial que no és apuntat per cap fletxa, és l'únic del joc que amb aquesta característica.

- La resta de nodes del joc són apuntats per una única fletxa.

- D'aquí es dedueix que hi ha un únic camí per arribar del node inicial a cada un dels nodes del joc. No hi ha dues formes diferents d'arribar a la mateixa solució final, les decisions són excloents.

En els arbres de decisió les decisions que s'escullen són lineals,[6] a mesura que vas seleccionant entre diverses opcions es van tancant altres, el que implica normalment que no hi ha marxa enrere. En general, les regles tenen una forma condicional:

if condició 1 i condició 2 i condició 3 llavors resultat

Aquestes regles solen venir implícites en el conjunt de dades arran del qual es construeix l'arbre de decisions. Les regles de decisió es poden generar construint regles d'associació amb la variable objectiu de la dreta. També poden denotar relacions temporals o causals.[7]

Exemple

[modifica]

En aquest arbre de decisió podem observar com hi ha quatre possibles solucions finals. En ell es compleixen les regles anteriorment descrites (node inicial, una única fletxa per node i un únic camí per arribar a cada node final) i té tots els elements descrits (node, vector de nombres, fletxes i etiquetes). La imatge representa un arbre de decisió conformat per dos jugadors. La primera decisió l'ha de prendre la jugadora 1, qui deu decidir entre O1 i O2, ara haurà de ser la jugadora 2 qui decideix. Si la jugadora 1 ha decidit O1, l'altra jugadora haurà de decidir entre A1 i R1, A1 li produirà una utilitat de 2, i R1 de 0, a la vegada A1 li reportarà una utilitat de 8 a la jugadora 1 i R1 de 0. En canvi, si la jugadora 1 escull O2, la jugadora 2 haurà de triar entre A2 i R2, la primera opció li reportarà una utilitat de 5 a ella i a l'altra jugadora, R2 reportarà una utilitat de 0 a les dues. Amb els mètodes d'inducció existents adequats es podria resoldre aquest arbre de decisió sense molta complicació.

Exemple d'anàlisi

[modifica]L'anàlisi pot tenir en compte la funció de preferència o utilitat del qui el du a terme (per exemple, de l'empresa), per exemple:

La interpretació bàsica en aquest cas és que l'empresa prefereix el risc i els beneficis de B sota coeficients de preferència de risc realistes (superiors a 400 dòlars), en aquest rang d'aversió al risc, l'empresa hauria de modelar una tercera estratègia, "Ni A ni B".

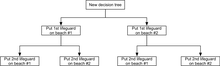

Un altre exemple, utilitzat habitualment en cursos d'investigació operativa, és la distribució de socorristes a les platges (també conegut com l'exemple "Life's a Beach").[8] L'exemple descriu dues platges amb socorristes que es distribuiran a cada platja. Hi ha un pressupost màxim B que es pot distribuir entre les dues platges (en total), i mitjançant una taula de retorn marginal, els analistes poden decidir quants socorristes destinar a cada platja.

| Socorristes a cada platja | Ofegaments previnguts en total, platja #1 | Ofegaments previnguts en total, platja #2 |

|---|---|---|

| 1 | 3 | 1 |

| 2 | 0 | 4 |

En aquest exemple, un arbre de decisions pot ser dibuixat per a il·lustrar la llei de rendiments de decreixement a la platja #1.

L'arbre de decisió il·lustra que quan els socorristes es distribueixen seqüencialment, col·locar primerament un socorrista a la platja #1 seria la millor opció si només hi hagués pressupost per a un socorrista. Però si hi ha pressupost per a dos socorristes, llavors col·locant-los als dos a la platja #2 previndran més ofegaments.

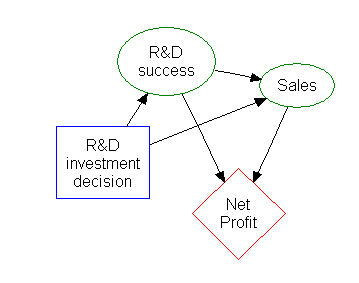

Diagrama d'influència

[modifica]Molta de la informació en un arbre de decisió pot ser representada més compacte com a diagrama d'influència, focalitzant l'atenció en els problemes i relacions entre esdeveniments.

Regla d'inducció

[modifica]Els arbres de decisió poden ser utilitzats com models generatius de regles d'inducció sobre dades empíriques. Un arbre de decisió optimal es pot definir com un arbre que considera la gran majoria de les dades, mentre minimitza el nombre de nivells (o preguntes). Hi ha diversos algorismes per generar aquests tipus d'arbres, com ID3[9]/4/5, CLS, ASSISTANT, i CART.

Avantatges i inconvenients

[modifica]Entre les diferents eines de decisió, els arbres de decisió tenen varies avantatges:

- Són fàcils d'entendre i de ser interpretats.

- Els resultats son valuosos fins i tot amb dades valuoses i pesades. Es pot extreure molt de coneixement expert que descriu algunes situacions (com poden ser alternatives, probabilitats i costos).

- Ajuda a determinar valors pitjors, millors i esperats per diferents escenaris.

- S’utilitza un model de caixa blanca, on es pot veure el procés en el qual el model ha arribat a un cert resultat però el procés no pot ser alterat.

- Es pot combinar amb altres tècniques de decisió.

- Es poden utilitzar més d'un arbre de decisió dins del mateix problema.

Els inconvenients dels arbres de decisió són:

- Aquests són inestables, és a dir, al mínim canvi produït en les dades d'entrada poden generar un canvi en la estructura òptima de l'arbre.

- Molt sovint són poc acurats. Altres predictors donen millors resultats amb dades similars. Una manera de solucionar-ho, podria ser generar un bosc aleatori d'arbres de decisió, però la interpretació d'aquest és una mica més complicada.

- Per dades que continguin variables categòriques amb diferent nombre de nivells, la informació que guanya l'arbre de decisió és esbiaixada pels atributs amb nivells més alts.

- Els càlculs es poden tornar molt complexes, sobretot si hi ha molts valors desconeguts i/o hi ha molta dependència entre les dades.

Optimització d'un arbre de decisió

[modifica]Cal tenir en compte algunes coses a l'hora de millorar la precisió del classificador de l'arbre de decisió. A continuació es mostren algunes optimitzacions possibles a tenir en compte a l'hora d'assegurar-se que el model d'arbre de decisions produït fa la decisió o classificació correcta. S’ha de tenir en compte que aquestes coses no són les úniques coses a considerar.

Augment del nombre de nivells de l'arbre

L'exactitud de l'arbre de decisió pot canviar en funció de la profunditat de l'arbre de decisió. En molts casos, les fulles de l'arbre són nodes purs.[10] Quan un node és pur, vol dir que totes les dades d'aquest node pertanyen a una sola classe.[11] Per exemple, si les classes del conjunt de dades són Càncer i No-Càncer, un node fulla es consideraria pur quan totes les dades de mostra d'un node fulla només formen part d'una classe, ja sigui Càncer o No-Càncer. És important tenir en compte que un arbre més profund no sempre és millor l'hora d'optimitzar l'arbre de decisió. Un arbre més profund pot influir en el temps d'execució de manera negativa. Si s'utilitza un determinat algorisme de classificació, un arbre més profund podria significar que el temps d'execució d'aquest algorisme de classificació és significativament més lent. També hi ha la possibilitat que l'algoritme que construeix l'arbre de decisió sigui significativament més lent a mesura que l'arbre es fa més profund. Si l'algoritme utilitzat divideix els nodes purs, es podria experimentar una disminució de la precisió general del classificador d'arbres. Ocasionalment, aprofundir en l'arbre pot provocar una disminució de la precisió en general, per la qual cosa és molt important fer proves modificant la profunditat de l'arbre de decisió i seleccionant la profunditat que produeixi els millors resultats. Els següents punts mostren un breu resum, sent el nombre D la profunditat de l'arbre.

Possibles avantatges d'augmentar D:

- La precisió del model de classificació de l'arbre de decisió augmenta.

Possibles desavantatges d'augmentar D:

- Problemes de temps d'execució

- Disminució de la precisió en general

- Les divisions de nodes purs mentre s'aprofundeix poden causar problemes.

La capacitat d'examinar les diferències en els resultats de classificació quan es canvia D és imprescindible. Hem de ser capaços de canviar i fer proves amb les variables que podrien afectar la precisió i la fiabilitat del model d'arbre de decisió fàcilment.

Elecció de les funcions de divisió de nodes

La funció de divisió de nodes utilitzada pot tenir un impacte en la millora de la precisió de l'arbre de decisió. Per exemple, utilitzar la funció de guany d'informació pot donar millors resultats que utilitzar la funció phi. La funció phi es coneix com una mesura de "bondat" d'un candidat dividit en un node de l'arbre de decisió. La funció de guany d'informació es coneix com una mesura de la "reducció de l'entropia". A continuació, construirem dos arbres de decisió. Es construirà un arbre de decisions mitjançant la funció phi per dividir els nodes i un arbre de decisions es construirà amb la funció de guany d'informació per dividir els nodes.

Els principals avantatges i desavantatges del guany d'informació i la funció phi són:

- Un inconvenient important del guany d'informació és que la característica que s'escull com el següent node de l'arbre tendeix a tenir més valors únics.[12]

- Un avantatge del guany d'informació és que tendeix a triar les característiques més importants que estan a prop de l'arrel de l'arbre. És una molt bona mesura per decidir la rellevància d'algunes característiques.

- La funció phi també és una bona mesura per decidir la rellevància d'algunes característiques en funció de la "bondat".

Aquesta és la fórmula de la funció de guany d'informació. La fórmula estableix que el guany d'informació és una funció de l'entropia d'un node de l'arbre de decisió menys l'entropia d'una divisió candidata al node t d'un arbre de decisió.

Aquesta és la fórmula de la funció phi. La funció phi es maximitza quan la característica escollida divideix les mostres d'una manera que produeixi divisions homogènies i tinguin aproximadament el mateix nombre de mostres a cada divisió.

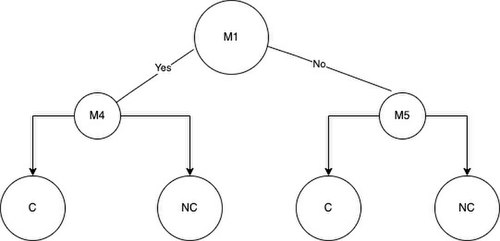

Establirem D, que és la profunditat de l'arbre de decisió que estem construint, a tres (D = 3). També tenim el següent conjunt de dades de mostres de Càncer i No-Càncer i les característiques de mutació que tenen o no les mostres. Si una mostra té una característica de mutació, la mostra és positiva per a aquesta mutació i es representarà amb un u. Si una mostra no té una característica de mutació, la mostra és negativa per a aquesta mutació i es representarà amb un zero.

En resum, C denota Càncer i NC denota No-Càncer. La lletra M denota Mutació, i si una mostra té una mutació particular, apareixerà a la taula com un u i, en cas contrari, un zero.

| M1 | M2 | M3 | M4 | M5 | |

|---|---|---|---|---|---|

| C1 | 0 | 1 | 0 | 1 | 1 |

| NC1 | 0 | 0 | 0 | 0 | 0 |

| NC2 | 0 | 0 | 1 | 1 | 0 |

| NC3 | 0 | 0 | 0 | 0 | 0 |

| C2 | 1 | 1 | 1 | 1 | 1 |

| NC4 | 0 | 0 | 0 | 1 | 0 |

Ara podem utilitzar les fórmules per calcular els valors de la funció phi i els valors de guany d'informació per a cada M del conjunt de dades. Un cop calculats tots els valors, es pot produir l'arbre. El primer que cal fer és seleccionar el node arrel. En el guany d'informació i la funció phi considerem que la divisió òptima és la mutació que produeix el valor més alt per al guany d'informació o la funció phi. Ara suposem que M1 té el valor de funció phi més alt i M4 té el valor de guany d'informació més alt. La mutació M1 serà l'arrel del nostre arbre de funcions phi i M4 serà l'arrel del nostre arbre de guany d'informació. Podeu observar els nodes arrel a continuació.

Un cop hem escollit el node arrel, podem dividir les mostres en dos grups en funció de si una mostra és positiva o negativa per a la mutació del node arrel. Els grups s'anomenaran grup A i grup B. Per exemple, si utilitzem M1 per dividir les mostres al node arrel obtenim les mostres NC2 i C2 al grup A i la resta de mostres NC4, NC3, NC1 i C1 al grup B.

Sense tenir en compte la mutació escollida per al node arrel, procediu a col·locar les següents millors característiques que tinguin els valors més alts de guany d'informació o la funció phi als nodes secundaris esquerre o dret de l'arbre de decisió. Un cop triem el node arrel i els dos nodes fills per a l'arbre de profunditat = 3, podem afegir les fulles. Les fulles representaran la decisió final de classificació que el model ha produït en funció de les mutacions que té o no una mostra. L'arbre esquerre és l'arbre de decisions que obtenim utilitzant el guany d'informació per dividir els nodes i l'arbre dret és el que obtenim utilitzant la funció phi per dividir els nodes.

Ara suposem que els resultats de la classificació dels dos arbres es donen mitjançant una matriu de confusió.

Matriu de confusió del guany d'informació:

| Predit: C | Predit: NC | |

| Real: C | 1 | 1 |

| Real: NC | 0 | 4 |

Matriu de confusió de la funció Phi:

| Predit: C | Predit: NC | |

| Real: C | 2 | 0 |

| Real: NC | 1 | 3 |

L'arbre que utilitza guany d'informació té els mateixos resultats quan s'utilitza la funció phi quan es calcula la precisió. Quan classifiquem les mostres segons el model que utilitzen el guany d'informació obtenim un veritable positiu, un fals positiu, zero falsos negatius i quatre veritables negatius. Per al model que utilitza la funció phi obtenim dos veritables positius, zero falsos positius, un fals negatiu i tres veritables negatius. El següent pas és avaluar l'eficàcia de l'arbre de decisions mitjançant algunes mètriques clau que s’esmentaran a la secció d'avaluació d'un arbre de decisions. Les mètriques que es comentaran a continuació poden ajudar a determinar els propers passos a seguir per optimitzar l'arbre de decisions.

Altres tècniques

A més de la tècnica explicada anteriorment, hi ha moltes més tècniques per millorar els models de classificació de l'arbre de decisió que construïm. Una de les tècniques és fer el nostre model d'arbre de decisions a partir d'un conjunt de dades d'arrencada. El conjunt de dades d'arrencada ajuda a eliminar el biaix que es produeix quan es construeix un model d'arbre de decisions amb les mateixes dades amb les quals es prova el model. La capacitat d'aprofitar el poder dels boscos aleatoris també pot ajudar a millorar significativament la precisió general del model que s'està construint. Aquest mètode genera moltes decisions a partir de molts arbres de decisions i suma els vots de cada arbre de decisions per fer la classificació final. Hi ha moltes tècniques, però l'objectiu principal és per proves amb la construcció del vostre model d'arbre de decisions de diferents maneres per assegurar-vos que assoleix el nivell de rendiment més alt possible.

Avaluant un arbre de decisió

[modifica]És important conèixer les mesures per avaluar un arbre de decisió. Les mètriques principals són: accuracy, sensitivitat, especificitat, precisió, la probabilitat de fals negatiu (miss rate), la false discovery rate i la false omission rate.

Totes aquestes mètriques deriven del nombre de vertader positius, falsos positius, vertaders negatius i falsos negatius[13] obtinguts quan s’executa una mostra de dades amb un arbre de decisió de classificació. També pot ser utilitzada una matriu de confusió per mostrar aquests resultats. Aquestes mètriques ens donen informació sobre els punts fors i febles del nostre model de classificació. Per exemple, una baixa sensitivitat amb una alta especificitat podria indicar que el model de classificació no dona bons resultats identificant mostres de càncer sobre mostres no cancerígenes.

Agafem ara la matriu de confusió que veiem a sota, sobre un model de classificació de gent que pot o no patir càncer. Aquesta ens indica que el nostre model de classificació basat en l'arbre de decisió dona 11 vertaders positius (VP), 1 fals positiu (FP), 45 falsos negatius (FN), i 105 vertaders negatius (VN).

| Predit: C | Predit: NC | |

|---|---|---|

| Valor real: C | 11 | 45 |

| Valor real: NC | 1 | 105 |

Calculem ara els valors d'accuracy, sensitivitat, especificitat, precisó, probabilitat de fals negatiu, false discovery rate, i false omission rate.

- Accuracy =

- Sensitivitat = vertader positiu ratio

- Especificitat = vertader negatiu ratio

- Precisió = valor positiu predit

- Probabilitat de fals negatiu = fals negatiu ratio

- False discovery rate =

- False omission rate =

Un cop tenim el resultat de totes les mètriques podem extreure informació sobre el nostre model. Laccuracy calculada és del 71.60%, valor que és prou bo per començar però voldrem que laccuracy sigui millor mentre mantenim el nostre model el més òptim possible.

El valor de la sensitivitat és de 19.64% que vol dir que aquest percentatge que fos positiu en càncer va donar positiu en test. Si mirem el valor d'especificitat, 99.06% de les mostres que eren negatives en càncer, realment van donar negatiu en test. És important que hi hagi un equilibri entre aquests dos valors, ja que si podem augmentar la sensitivitat arrel de disminuir l'especificitat és un resultat beneficiós pel model.

Aquest era un exemple de com extreure informació sobre les mètriques per tal de millorar en les pròximes iteracions del model.

Exemples d'aplicacions dels arbres de decisió

[modifica]Arbres de decisió en Teoria de jocs

[modifica]A teria de jocs són utilitzats els arbres de decisió, ja que s’utilitzen models per estudiar interaccions entre diferents estructures de dades. Aquesta manera d'aplicar un arbre de decisió s’utilitza en diversos camps: economia, política, biologia, sociologia, psicologia, filosofia i ciència de computació entre altres.

En la teoria de jocs els arbres de decisió són utilitzats de manera extensiva, que modelitza jocs que presenten un ordre concret. Aquests sempre comencen amb un node inicial del qual surten diferents fletxes que es dirigeixen cap a altres nodes, i es reprodueix la metodologia explicada més amunt arribant cada branca a un vector de números. També és possible que els jocs de forma extensiva modelin jocs simultanis, aquests es representen amb una línia discontínua entre els nodes que ha d'escollir un jugador sense saber l'opció que escollirà l'altre, aquest pren un vector de decisions anticipat sense saber en quin dels nodes estarà. Un exemple, d'aquesta metodologia podria ser el joc de pedra, paper o tisora.

Accions simultànies en arbres de decisió

[modifica]Un tipus de variant on els arbres de decisió són utilitzats és en els jocs simultanis, tal com hem comentat anteriorment.

Els jocs simultanis són aquells jocs on els jugadors prenen una decisió a la vegada, i per tant cap d'ells es pot anticipar a la decisió de l'altre. Un exemple clar és el joc de pedra, paper o tisora, on els jugadors han d'escollir entre aquestes tres opcions a la vegada.

Els arbres de decisió d'aquest tipus de problemes es representen afegint una variant a aquests, com el jugador número dos no sap en quin node es troba, és a dir, podria estar en qualsevol, els nodes doncs estan units per una línia discontínua mostrant que no se sap en quin node pot estar. D’aquesta manera la decisió d'aquest jugador serà completament independent a la decisió de l'altre.

Arbres de decisió en el disseny d'aplicacions informàtiques

[modifica]Dins del disseny d'aplicacions informàtiques, un arbre de decisió indica les accions a realitzar en funció del valor d'una o varies variables. És una representació en forma d'arbre on les branques es bifurquen en funció dels valors que prenen les variables i on els nodes fulles representen una acció concreta. S’acostumen a utilitzar quan el número de condicions no es massa gran (en aquest cas, es millor utilitzar una taula de decisions).

Concretament, si ens centrem, per exemple, en l'àmbit empresarial, podem dir que els arbres de decisió són diagrames de decisió seqüencial, els quals ens mostren els possibles resultats.

Aquests ajuden a les empreses a determinar quines són les opcions que tenen al veure les diferents decisions i resultats. L'opció que evita una pèrdua o produeix una benefici extra té un valor. L'habilitat de crear una opció, i per tant, té un valor que pot ser comprat o venut.

Referències

[modifica]- ↑ «Decision Trees in Machine Learning – Towards Data Science». Towards Data Science, 17-05-2017.

- ↑ «What is a Decision Tree Diagram» (en anglès). Lucidchart, 24-09-2017.

- ↑ «Chapter 4: Decision Trees Algorithms» (en anglès). https://medium.com,+06-10-2017.+[Consulta: 6 novembre 2018].

- ↑ «Decision Tree» (en anglès). https://www.saedsayad.com.+[Consulta: 6 novembre 2018].

- ↑ Kamiński, B.; Jakubczyk, M.; Szufel, P. «A framework for sensitivity analysis of decision trees». Central European Journal of Operations Research, 26, 1, 2017, pàg. 135–159. DOI: 10.1007/s10100-017-0479-6. PMC: 5767274. PMID: 29375266.

- ↑ Quinlan, J. R. «Simplifying decision trees». International Journal of Man-Machine Studies, 27, 3, 1987, pàg. 221–234. DOI: 10.1016/S0020-7373(87)80053-6.

- ↑ K. Karimi and H.J. Hamilton (2011), "Generation and Interpretation of Temporal Decision Rules", International Journal of Computer Information Systems and Industrial Management Applications, Volume 3

- ↑ Wagner, Harvey M. Principles of Operations Research: With Applications to Managerial Decisions (en anglès). 2a edició. Englewood Cliffs, NJ: Prentice Hall, 1975-09-01. ISBN 9780137095926.

- ↑ Utgoff, Paul E. «Incremental Induction of Decision Trees» (en anglès). Machine Learning, 4, 2, 01-11-1989, pàg. 161–186. DOI: 10.1023/A:1022699900025. ISSN: 1573-0565.

- ↑ Larose, Chantal, Daniel. Discovering Knowledge in Data (en anglès). Hoboken, NJ: John Wiley & Sons, 2014, p. 167. ISBN 9780470908747.

- ↑ Plapinger, Thomas. «What is a Decision Tree?», 29-07-2017. Arxivat de l'original el 10 desembre 2021. [Consulta: 5 desembre 2021].

- ↑ Tao, Christopher. «Do Not Use Decision Tree Like Thus», 06-09-2020. Arxivat de l'original el 10 desembre 2021. [Consulta: 10 desembre 2021].

- ↑ «False positives and false negatives» (en anglès). From Wikipedia, the free encyclopedia, 26-12-2022.

![{\displaystyle [VP/(VP+FN)]-}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94232b9831a7f1f4a893de1e1c1f8eea2f233840)