Xarxa neuronal residual

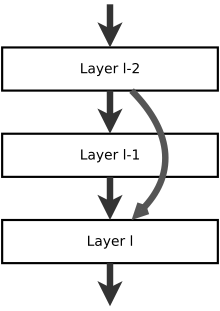

Una xarxa neuronal residual (amb acrònim anglès ResNet) [1] és una xarxa neuronal artificial (ANN). És una variant sense porta o oberta de la HighwayNet,[2] la primera xarxa neuronal de feedforward molt profunda que funciona amb centenars de capes, molt més profundes que les xarxes neuronals anteriors. Les connexions o dreceres de saltar s'utilitzen per saltar per sobre d'algunes capes (HighwayNets també pot aprendre els pesos de salt per si mateixos mitjançant una matriu de pes addicional per a les seves portes). Els models típics de ResNet s'implementen amb salts de doble o triple capa que contenen no linealitats (ReLU) i normalització per lots entremig. Els models amb diversos salts paral·lels s'anomenen DenseNets.[3] En el context de les xarxes neuronals residuals, una xarxa no residual es pot descriure com una xarxa simple.

Igual que en el cas de les xarxes neuronals recurrents de memòria a llarg termini [4] hi ha dos motius principals per afegir connexions de salt: per evitar el problema dels gradients de fuga, donant lloc a una optimització més fàcil de les xarxes neuronals, on els mecanismes de gating. facilitar el flux d'informació a través de moltes capes ("autopistes de la informació"), [5] o mitigar el problema de la Degradació (saturació de la precisió); on afegir més capes a un model adequadament profund condueix a un error d'entrenament més alt.[6] Durant l'entrenament, els pesos s'adapten per silenciar la capa aigües amunt, i amplifiqui la capa prèviament omesa. En el cas més senzill, només s'adapten els pesos per a la connexió de la capa adjacent, sense pesos explícits per a la capa aigües amunt. Això funciona millor quan es passa una sola capa no lineal o quan les capes intermèdies són totes lineals. En cas contrari, s'hauria d'aprendre una matriu de pes explícita per a la connexió omesa (s'hauria d'utilitzar una HighwayNet).

Saltar-se simplifica eficaçment la xarxa, utilitzant menys capes en les etapes de formació inicial. Això accelera l'aprenentatge reduint l'impacte dels gradients que s'esvaeixen,[7] ja que hi ha menys capes per propagar-se. Aleshores, la xarxa restaura gradualment les capes omeses a mesura que aprèn l'espai de les característiques. Cap al final de l'entrenament, quan totes les capes s'expandeixen, es manté més a prop del col·lector i així aprèn més ràpidament. Una xarxa neuronal sense parts residuals explora més de l'espai de característiques. Això fa que sigui més vulnerable a les pertorbacions que fan que surti del col·lector i requereixen dades d'entrenament addicionals per recuperar-se.

Es va utilitzar una xarxa neuronal residual per guanyar el concurs ImageNet [8] 2015,[9] i s'ha convertit en la xarxa neuronal més citada del segle xxi.[10]

Referències

[modifica]- ↑ (2016) "Deep Residual Learning for Image Recognition".

- ↑ Highway Networks.

- ↑ (2017) "Densely Connected Convolutional Networks".

- ↑ Sepp Hochreiter; Jürgen Schmidhuber Neural Computation, 9, 8, 1997, pàg. 1735–1780. DOI: 10.1162/neco.1997.9.8.1735. PMID: 9377276.

- ↑ Srivastava, Rupesh K; Greff, Klaus; Schmidhuber, Juergen Advances in Neural Information Processing Systems 28, 28, 2015, pàg. 2377–2385.

- ↑ (2016) "Deep Residual Learning for Image Recognition".

- ↑ (tesi) (en anglès). diploma, 28-02-2023.

- ↑ Deng, Jia; Dong, Wei; Socher, Richard; Li, Li-Jia; Li, Kai CVPR, 2009.

- ↑ (2016) "Deep Residual Learning for Image Recognition".

- ↑ «The most cited neural networks all build on work done in my labs». , 2021 [Consulta: 30 abril 2022].